美移民局報告由AI「看圖作文」 聯邦法官質疑可信性

發佈時間:19:42 2025-11-27 HKT

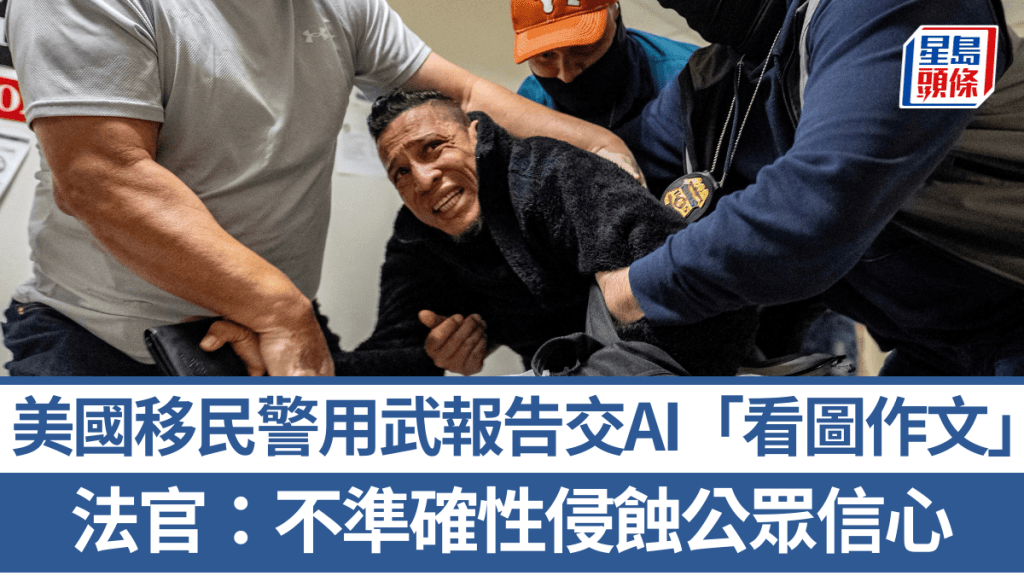

美國一名聯邦法官近日在一份長篇法庭意見的註腳中,嚴厲批評移民局探員讓人工智能(AI)「代筆」撰寫武力使用報告。

助長不準確性 侵蝕公眾信心

法官指出,這種做法可能助長不準確性,並進一步侵蝕公眾對執法部門在芝加哥地區處理移民鎮壓及後續抗議活動的信心。

美國地方法院法官埃利斯(Sara Ellis)在上周發布的223頁長篇意見書中強調,使用ChatGPT來撰寫這些報告,不僅損害了探員的可信度,而且「可能解釋了這些報告為何不準確」。她指出,在至少一段隨身攝錄機的影片中,觀察到一名探員在向程式提供一個簡短的描述性句子和幾張圖片後,指示ChatGPT生成敘述報告。而官方執法記錄與隨身攝錄機影片所揭示的事實之間存在差異。

犯罪學專家:噩夢般的場景

南卡羅來納大學(University of South Carolina)犯罪學助理教授亞當斯(Ian Adams)表示:「這個傢伙所做的,是所有可能情況中最糟糕的。如果他真的只給了一句話和幾張圖片,那這就違背了我們所有的建議。這是一個噩夢般的場景。」

法院在審議使用武力是否合理時,已確立了「客觀合理性」的標準,此標準在很大程度上依賴於特定警員在特定情境下的視角。亞當斯補充說:「我們需要該事件的具體陳述和該警員的具體想法,才能判斷這是否是合理使用武力。」

除了擔心AI代筆報告不能準確地描述事件,使用人工智能還引發了潛在的隱私問題。紐約大學法學院(NYU School of Law)警務項目(Policing Project)的幕僚長兼技術政策顧問金賽(Katie Kinsey)指出,如果涉事探員是用公開版本的ChatGPT,他可能沒有意識到,在上傳圖片的那一刻,他就失去了對這些圖像的控制權,使其可能成為公共領域的一部分,並被不法分子利用。

AI模型以為還是實際發生?

喬治華盛頓大學法學院(George Washington University Law School)的法學教授弗格森(Andrew Guthrie Ferguson)表示:「你問任何一位人工智能專家,他們都會告訴你,不同的AI應用程式對提示的回應結果大相徑庭,而視覺元素的加入會讓情況變得更加複雜。這也關乎專業性問題,我們不希望法庭上出現的是模型認為應該發生的事,而不是實際發生的事。」