美移民局报告由AI「看图作文」 联邦法官质疑可信性

发布时间:19:42 2025-11-27 HKT

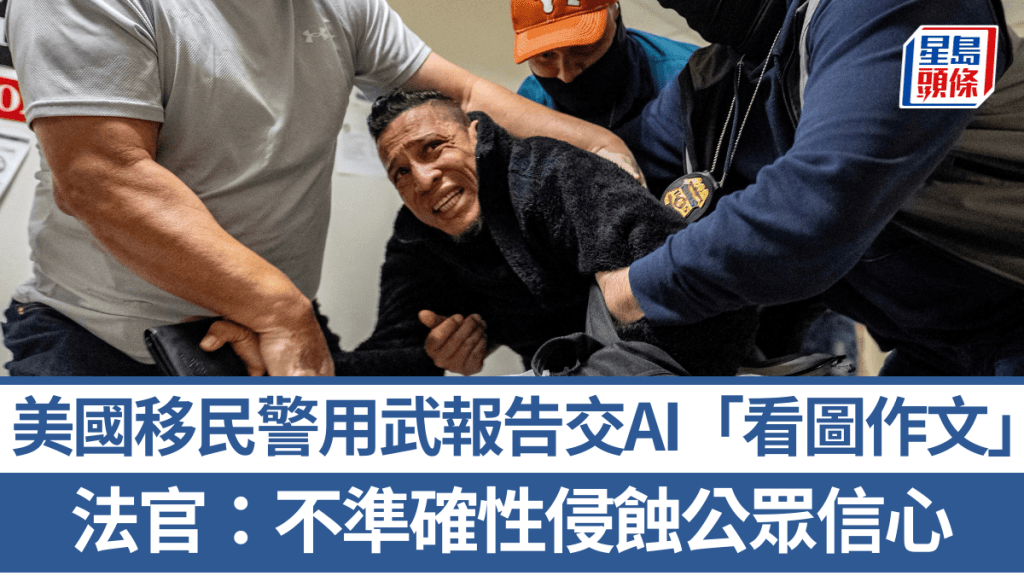

美国一名联邦法官近日在一份长篇法庭意见的注脚中,严厉批评移民局探员让人工智能(AI)「代笔」撰写武力使用报告。

助长不准确性 侵蚀公众信心

法官指出,这种做法可能助长不准确性,并进一步侵蚀公众对执法部门在芝加哥地区处理移民镇压及后续抗议活动的信心。

美国地方法院法官埃利斯(Sara Ellis)在上周发布的223页长篇意见书中强调,使用ChatGPT来撰写这些报告,不仅损害了探员的可信度,而且「可能解释了这些报告为何不准确」。她指出,在至少一段随身摄录机的影片中,观察到一名探员在向程式提供一个简短的描述性句子和几张图片后,指示ChatGPT生成叙述报告。而官方执法记录与随身摄录机影片所揭示的事实之间存在差异。

犯罪学专家:噩梦般的场景

南卡罗来纳大学(University of South Carolina)犯罪学助理教授亚当斯(Ian Adams)表示:「这个家伙所做的,是所有可能情况中最糟糕的。如果他真的只给了一句话和几张图片,那这就违背了我们所有的建议。这是一个噩梦般的场景。」

法院在审议使用武力是否合理时,已确立了「客观合理性」的标准,此标准在很大程度上依赖于特定警员在特定情境下的视角。亚当斯补充说:「我们需要该事件的具体陈述和该警员的具体想法,才能判断这是否是合理使用武力。」

除了担心AI代笔报告不能准确地描述事件,使用人工智能还引发了潜在的隐私问题。纽约大学法学院(NYU School of Law)警务项目(Policing Project)的幕僚长兼技术政策顾问金赛(Katie Kinsey)指出,如果涉事探员是用公开版本的ChatGPT,他可能没有意识到,在上传图片的那一刻,他就失去了对这些图像的控制权,使其可能成为公共领域的一部分,并被不法分子利用。

AI模型以为还是实际发生?

乔治华盛顿大学法学院(George Washington University Law School)的法学教授弗格森(Andrew Guthrie Ferguson)表示:「你问任何一位人工智能专家,他们都会告诉你,不同的AI应用程式对提示的回应结果大相径庭,而视觉元素的加入会让情况变得更加复杂。这也关乎专业性问题,我们不希望法庭上出现的是模型认为应该发生的事,而不是实际发生的事。」