AI數據中心用電需求急增

發佈時間:03:00 2025-09-12 HKT

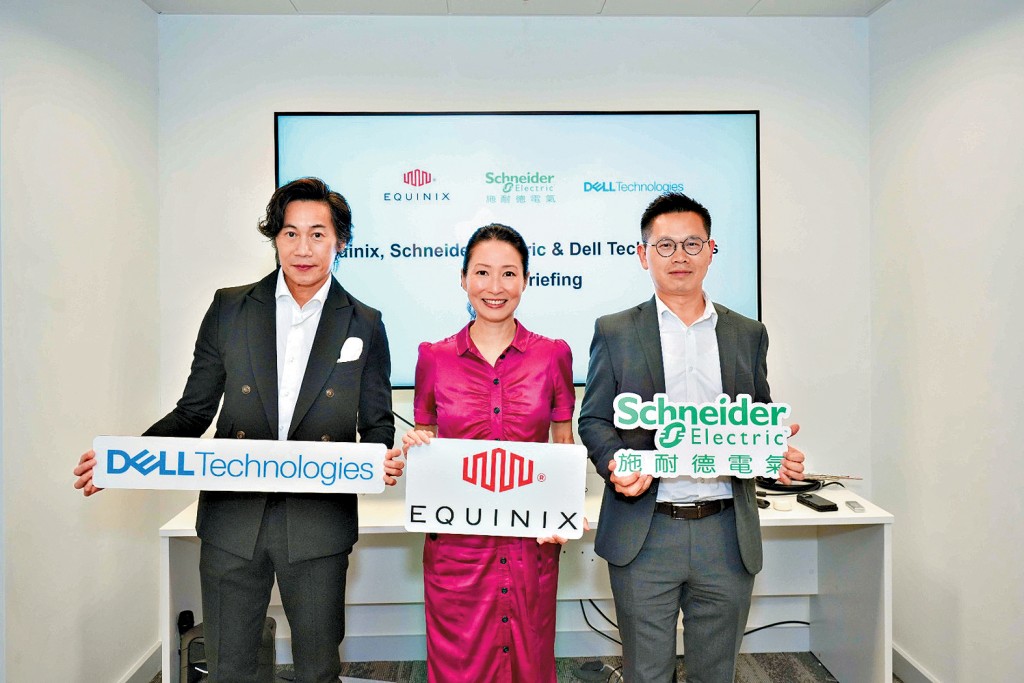

人工智能(AI)不止影響科技格局,同時正在重塑能源市場,主因訓練AI和高效能運算需要大量電力,並對全球數據中心的散熱功能帶來挑戰,令液體冷卻技術應運而生。數碼基礎設施公司Equinix最新宣布,與Dell Technologies及施耐德電氣合作,於Equinix HK1數據中心利用液體冷卻技術,為高功率密度(HPD)的AI運算伺服器降溫。

高盛一項研究指出,預計至2027年用電需求將增加50%,而到2030年更可能達到165%增長。另一方面,傳統的數據中心散熱方式主要依賴風冷系統,利用空調和風扇將熱量傳遞給空氣,再將熱空氣排出或與冷空氣混合,例如通過架空地板等方式來分離和引導氣流,以達到為設備散熱的目的,但這種方式在高熱負載的數據中心已顯不足。

傳統空調系統能源效益極低

施耐德電氣香港區總裁趙啟文回憶道,20年前自己剛剛入行時,每個機櫃的功耗普遍在1.5千瓦左右,到後來慢慢發展至20至30千瓦;而在當今AI運算的情況下,功耗動輒超過100千瓦。他直言,AI只會不斷發展,數據中心對高密度運算及高能源效益基礎的需求,也只會持續變高。在如此高的密度下,傳統電腦機櫃空調系統(CRAC)已無法有效將熱能帶走。

Equinix香港區董事總經理韓祖恩亦表示,傳統依賴空氣調節的散熱方式,在面對現今AI伺服器的高熱負載時已漸見樽頸,單純增加風扇抽風,能源效益極低。

液體傳導熱量比空氣高3000倍

為解決高密度伺服器的散熱問題,Equinix與Dell Technologies及施耐德電氣合作,嘗試在Equinix HK1數據中心設置50千瓦機櫃式直達芯片(Direct-to-chip)液體冷卻系統。

根據介紹,液體冷卻設備每個機櫃的冷卻容量高達150千瓦,是傳統空氣冷卻系統的30倍。同時由於液體(導熱式冷卻)能傳導的熱量比空氣高逾 3,000倍,能更直接高效地將伺服器晶片這類核心發熱源產生的熱能帶走。

另外,傳統電腦機櫃空調(CRAC)系統的電源使用效率(PUE)為1.4至1.5,採用液體冷卻技術後,數據中心PUE可降至1.2或更低。據估算,若於數據中心中全面推行液體冷卻系統,每座數據中心每年更可節省逾2,000兆瓦時,即200萬度電的能源,相當於約500戶香港家庭的年用電量。

可應用現有基礎建設及擴展

在此次多方合作中,Equinix HK1數據中心安裝了Dell的直達晶片液冷伺服器,作為高速運算核心;施耐德電氣作為能源基建專家,引進最新的機櫃式液體冷卻分配裝置(CDU)系統,確保AI晶片穩定運作;中華電力則從能源審核及顧問角度,推動業界採納更節能的方案。

值得注意的是,液冷技術可以直接應用在現有的基礎建設當中,毋須大規模改動基建亦可升級。而今次示範就以營運超過20年的Equinix HK1數據中心作為場地,並在一個標準的1.2米深機櫃內部署液冷系統;根據介紹,「AI就緒」數據中心方案是全方位且可擴展的,未來可擴展至整個房間、甚至高達2兆瓦的大型獨立冷卻系統,客戶可根據業務增長逐步增加投資,以避免前期不必要的巨大開支。

新建50多個數據中心

另外,韓祖恩指出,在全球新建50多個數據中心,各地客戶需求均不一樣,而香港客戶則主要以金融服務業為主,十分接受液體冷卻技術,特別是應付未來AI工作量需求。因此,除了Equinix HK1數據中心會試用此項新技術外,預計Equinix明年第一季落成的數據中心「HK6」,也將會大量採用液體冷卻技術的設計。